近日,一则“科学家联名抵制韩国研发基于人工智能技术(AI)的自主武器(战斗机器人)”的消息引起广泛关注。英国《卫报》报道称,全球50多名顶尖学者联名签署公开信,断绝与韩国高级科学技术院的合作交流,原因是该院正与本国军火商韩华系统公司合作,寻求研发人工智能武器。

尽管韩国人否认试图研制“任何脱离人类控制的致命性自主武器或机器人士兵”,但越来越多人感觉到,战斗机器人实际成为各国军方角力的技术制高点,“机器人杀手”出征只是时间问题。

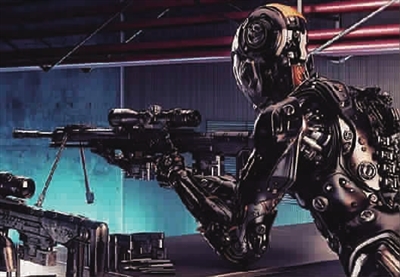

“终结者”接管战场

基于人工智能的战斗机器人(或称“机器人士兵”)可在不受操作手控制之下消灭目标,被称为继火药、核武器之后的“第三次战场革命”。按照英国简氏防务信息集团的定义,军用无人机可视为“初级阶段”的机器人士兵,目前已投入大批量实战部署阶段,自从美军MQ-1“掠夺者”无人机首次空袭阿富汗塔利班后,攻击型无人机便证明其作为致命武器的价值,使用范围和频率迅速增加。美军无人机战术吸引了世界的目光,现有86个国家拥有相似无人机,“连恐怖分子也在关注这项技术”。

继无人机之后,地面战斗机器人也进入试验性部署阶段,2015年底,叙利亚政府军和俄军携手围攻拉塔基亚郊外被极端组织盘踞的高地,成为人类第一场以战斗机器人为主的攻坚战。俄军投入4台履带式战斗机器人、2台轮式战斗机器人和至少一架无人机。在遥控指挥下,这些使用机枪和反坦克导弹的机器人冲锋在前,叙军士兵则躲在安全距离外打扫战场。机器人士兵的“不死之躯”和猛烈火力让敌人毫无还手之力,战斗只持续了20分钟便结束了,约70名极端分子被击毙,叙军仅4人受伤。美国《大众科技》惊呼,“终结者”已走在接管战场的路上。专家预测,到2040年,参战美军会有一半以上是机器人,未来机器人士兵成建制规模化作战也逐步从科幻电影变成现实。

直接参与战斗只是机器人士兵将担负的任务之一,更多时候,它们还扮演着哨兵、工兵及卫生兵角色。五角大楼称,数以万计的地面摇控机器人已在伊拉克战场进行试验性部署,并帮助美军排除、摧毁大量路边炸弹。美军发言人从另一个角度承认了机器人士兵的广泛部署:“多达1000辆无人车辆已在伊拉克和阿富汗被炸毁,但它们挽救了无数生命。”

韩国也是醉心于机器人士兵部署的国家之一。韩国《东亚日报》透露,韩军已在韩朝“非军事区”部署了警戒机器人,它配有5.56毫米机枪和40毫米榴弹发射器,发现威胁后会通知指挥中心,由操作手决定是否开火。

澳大利亚新南威尔士大学教授托比·沃尔什称,与核武器研发相比,战斗机器人研制容易、制造成本低,更适合大批量制造。连军费捉襟见肘的英国也不甘落后,BAE系统公司已研制出能完全自主运行的“塔拉尼斯”无人机。

威胁不亚于核武器

可以预见,采用人工智能的未来军用机器人肯定比今天同类机器人拥有更大自主性和更致命的攻击性,它们会不会像电影《终结者》描绘的那样“活”过来甚至发疯失控呢?1978年9月,日本一家工厂的切割机器人突然“发疯”,把正在值班的工人当成钢板切割了,这是历史上首起机器人杀人事件。自那以后,人们就开始不断想象机器人失控的可能性。

“如果失控的是拥有致命火力的军用机器人,那么后果更不堪设想。”奋进机器人公司的首席执行官希恩·比拉特称,一切人造物品都会存在缺陷,军用机器人也不例外。“有朝一日,人类非常有可能因一处小小的疏忽而失去对人工智能机器人的控制。”

这种担心让众多学者对如火如荼的战斗机器人项目提出质疑和担心。为此,参加2017年人工智能国际会议的所有专家联名签署公开信,呼吁禁止研制不受人工控制的攻击型战斗机器人。

除了担心军用机器人失控,更多人认为批量装备智能型自主武器的危险不亚于核武器扩散。宗教界人士西尔瓦诺·托马西表示,先进的智能型军用装置会“加大富国与穷国之间的权力差距”。我们需要注意,武装机器人的魅力和它们所产生的力量感,它们的使用可能不再仅限于正当防卫,而是‘无所不能’”。《卫报》指出,拥有智能型作战机器人的国家即使没有核武器,也会“让邻国的不安全感成倍增加”,“最终可能会导致国家间的大规模军备竞赛,甚至爆发武装冲突”。

更令人担心的是,战斗机器人一旦大批量生产,很可能有“漏网之鱼”流入黑市,取代炸弹成为恐怖分子手里的屠杀工具。“他们可以用它实施刺杀、颠覆、叛乱等活动,不顾任何伦理约束,无数平民将因此受到伤害。”全球人工智能专家在致韩国高级科学技术院的公开信中称:“这个‘潘多拉的盒子’一旦打开,将很难关闭。”

脖上“缰绳”不能松

但无论有多少反对声音,军用人工智能机器人研发已成为不可阻挡的潮流,所以更理性的思考应该是未雨绸缪。《卫报》认为,“目前最好的应对方式是始终握紧勒在机器人脖子上的那根缰绳。”也就是说,无论未来军用机器人发展到哪一步,人工控制和干预原则都不能放弃,最终做出开火决定的,只能是人类。无人机使用就是很好的例子,今天的无人机可在监视区域有效发现和识别敌对目标,并自动飞往选定地点,使用花样繁多的武器。但人在决策中的绝对地位始终未变。

随着军用人工智能日益成为作战行动中的关键要素,人们应该对战争的道德伦理基础进行重新分析、审查和检验,尽早制定相应的法律法规和技术防护措施。这套法律规则的核心内容是:人类必须居于指挥链的最高层级,永远高于机器;不允许技术建立或修正相关参数指标(包括交战规则),不允许一架机器向其他机器下达决定人类生死的命令。同时,全球各国还应展开相关讨论,就战时人工智能的使用达成基本共识并建立相应的法律框架。

另外,专家认为还要强化人员的专业素质。首先要建立人工智能程序员的专业标准。向人工智能发布命令看似简单实际却异常复杂,必须设定清晰的参数指标,确保人工智能能得到正确使用,从而大幅减少可能出现的人员伤亡。其次,要督促设计人员把好程序设计决策关,确保“杀伤链”处理软件和编程代码源头的安全可靠,并由国家掌控,以防止潜在的网络后门。